Databend[1] 是一个面向分析型工作负载优化的 OLAP 数据库,采用列式存储架构。在处理 CDC(Change Data Capture,变更数据捕获)场景时,如果直接执行单条的 UPDATE 和 DELETE 操作,会严重影响性能,无法充分发挥 Databend 在批处理方面的优势。

在 PR #9661[2] 之前,SeaTunnel 的 Databend sink connector 仅支持批量 INSERT 操作,缺乏对 CDC 场景中 UPDATE 和 DELETE 操作的高效处理能力。这限制了在实时数据同步场景中的应用。

核心问题与挑战

在 CDC 场景中,主要面临以下挑战:

-

性能瓶颈

逐条执行 UPDATE/DELETE 操作会产生大量的网络往返和事务开销

-

资源消耗

频繁的单条操作无法利用 Databend 的列式存储优势

-

数据一致性

需要确保变更操作的顺序性和完整性

-

吞吐量限制

传统方式难以应对高并发大数据量的 CDC 事件流

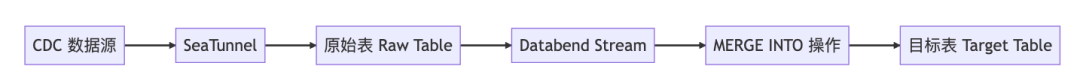

解决方案架构

整体设计思路

新的 CDC 模式通过以下创新设计实现高性能数据同步:

核心组件

1. CDC 模式激活机制

当用户在配置中指定

conflict_key

sink {

Databend {

url = "jdbc:databend://databend:8000/default?ssl=false"

user = "root"

password = ""

database = "default"

table = "sink_table"

# Enable CDC mode

batch_size = 100

conflict_key = "id"

allow_delete = true

}

}

2. 原始表设计

系统自动创建一个临时原始表来存储 CDC 事件:

CREATE TABLE IF NOT EXISTS raw_cdc_table_${target_table} (

id VARCHAR, -- 主键标识

table_name VARCHAR, -- 目标表名

raw_data JSON, -- 完整的行数据(JSON 格式)

add_time TIMESTAMP, -- 事件时间戳

action VARCHAR -- 操作类型:INSERT/UPDATE/DELETE

)

3. Stream 机制

利用 Databend Stream[3] 功能监控原始表的变化:

CREATE STREAM IF NOT EXISTS stream_${target_table}

ON TABLE raw_cdc_table_${target_table}

Stream 的优势:

- 增量处理:只处理新增的变更记录

- 事务保证:确保数据不丢失

- 高效查询:避免全表扫描

4. 两阶段处理模型

第一阶段:数据写入

- SeaTunnel 将所有 CDC 事件(INSERT/UPDATE/DELETE)以 JSON 格式写入原始表

- 支持批量写入,提高吞吐量

第二阶段:合并处理

- 基于 seatunnel AggregatedCommitter 定期执行 MERGE INTO 操作

- 将原始表的数据合并到目标表

MERGE INTO 核心逻辑

MERGE INTO target_table AS t

USING (

SELECT

raw_data:column1::VARCHARAS column1,

raw_data:column2::INTAS column2,

raw_data:column3::TIMESTAMPAS column3,

action,

id

FROM stream_${target_table}

QUALIFY ROW_NUMBER() OVER(

PARTITIONBY _id

ORDERBY _add_time DESC

) = 1

) AS s

ON t.id = s.id

WHENMATCHEDAND s._action = 'UPDATE'THEN

UPDATESET *

WHENMATCHEDAND s._action = 'DELETE'THEN

DELETE

WHENNOTMATCHEDAND s._action != 'DELETE'THEN

INSERT *

实现细节

关键代码实现

根据 PR #9661[2] 的实现,主要涉及以下核心类:

DatabendSinkWriter 增强

public class DatabendSinkWriter extends AbstractSinkWriter {

privateboolean cdcMode;

private String rawTableName;

private String streamName;

private ScheduledExecutorService mergeExecutor;

@Override

public void write(SeaTunnelRow element) throws IOException {

if (cdcMode) {

// CDC 模式:写入原始表

writeToRawTable(element);

} else {

// 普通模式:直接写入目标表

writeToTargetTable(element);

}

}

private void performMerge(List aggregatedCommitInfos) {

// Merge all the data from raw table to target table

String mergeSql = generateMergeSql();

log.info("[Instance {}] Executing MERGE INTO statement: {}", instanceId, mergeSql);

try (Statement stmt = connection.createStatement()) {

stmt.execute(mergeSql);

log.info("[Instance {}] Merge operation completed successfully", instanceId);

} catch (SQLException e) {

log.error(

"[Instance {}] Failed to execute merge operation: {}",

instanceId,

e.getMessage(),

e);

thrownew DatabendConnectorException(

DatabendConnectorErrorCode.SQL_OPERATION_FAILED,

"Failed to execute merge operation: " + e.getMessage(),

e);

}

}

}

配置选项扩展

在

DatabendSinkOptions

public class DatabendSinkOptions {

publicstaticfinal Option CONFLICT_KEY =

Options.key("conflict_key")

.stringType()

.noDefaultValue()

.withDescription("Conflict key for CDC merge operations");

publicstaticfinal Option ALLOW_DELETE =

Options.key("allow_delete")

.booleanType()

.defaultValue(false)

.withDescription("Whether to allow delete operations in CDC mode");

}

批处理优化策略

系统采用双重触发机制执行 MERGE 操作:

-

基于数量

当累积的 CDC 事件达到

时触发batch_size -

基于时间

seatunnel 的 checkpoint.interval 达到后触发

if (isCdcMode && shouldPerformMerge()) {

performMerge(aggregatedCommitInfos);

}

性能优势

批量处理优化

传统方式:1000 条更新 = 1000 次网络往返

CDC 模式:1000 条更新 = 1 次批量写入 + 1 次 MERGE 操作

**

列式存储利用**

- MERGE INTO[4] 操作充分利用 Databend 的列式存储特性

- 批量更新时只需扫描相关列,减少 I/O 开销

资源效率提升

- 减少连接开销

- 降低事务管理成本

- 提高并发处理能力

使用示例

完整配置示例

env{

parallelism = 1

job.mode = "STREAMING"

checkpoint.interval = 1000

}

source {

MySQL-CDC {

base-url="jdbc:mysql://127.0.0.1:3306/mydb"

username="root"

password="123456"

table-names=["mydb.t1"]

startup.mode="initial"

}

}

sink {

Databend {

url = "jdbc:databend://127.0.0.1:8009?presigned_url_disabled=true"

database = "default"

table = "t1"

user = "databend"

password = "databend"

batch_size = 2

auto_create = true

interval = 3

conflict_key = "a"

allow_delete = true

}

}

监控与调试

-- 查看 Stream 状态

SHOW STREAMS;

-- 查看原始表数据量

SELECT COUNT(*) FROM raw_cdc_table_users;

-- 查看待处理的变更

SELECT action, COUNT(*)

FROM stream_users

GROUP BY action;

错误处理与容错

1.重试机制

2. 数据一致性保证

- 使用 确保只处理最新的变更

QUALIFY ROW_NUMBER()

Stream 机制保证不丢失数据

- 支持 checkpoint 恢复

3.资源清理

-- 定期清理已处理的原始表数据

DELETE FROM raw_cdc_table_users

WHERE _add_time < DATEADD(day, -7, CURRENT_TIMESTAMP());

未来优化方向

- 智能批处理:根据数据特征动态调整批处理大小

- Schema 演进:自动处理表结构变更

- 监控指标:集成更完善的性能监控

总结

通过引入 Stream 和 MERGE INTO 机制,SeaTunnel 的 Databend sink connector 成功实现了高性能的 CDC 支持。这一创新方案不仅大幅提升了数据同步性能,还保证了数据一致性和可靠性。对于需要实时数据同步的 OLAP 场景,这一功能提供了强大的技术支撑。

引用链接

[1]

[2]

[3]

[4]

关于 Databend

Databend 是一款开源、弹性、低成本,基于对象存储也可以做实时分析的新式湖仓。期待您的关注,一起探索云原生数仓解决方案,打造新一代开源 Data Cloud。

👨💻 Databend Cloud:https://databend.cn

📖 Databend 文档:https://docs.databend.com

💻Wechat:Databend

✨GitHub:https://github.com/databendlabs/databend

订阅我们的新闻简报

及时了解功能发布、产品规划、支持服务和云服务的最新信息!